La trastienda tecnológica de las revoluciones científicas

Sobre Higgs y los hombros de gigantes de hierro y vidrio

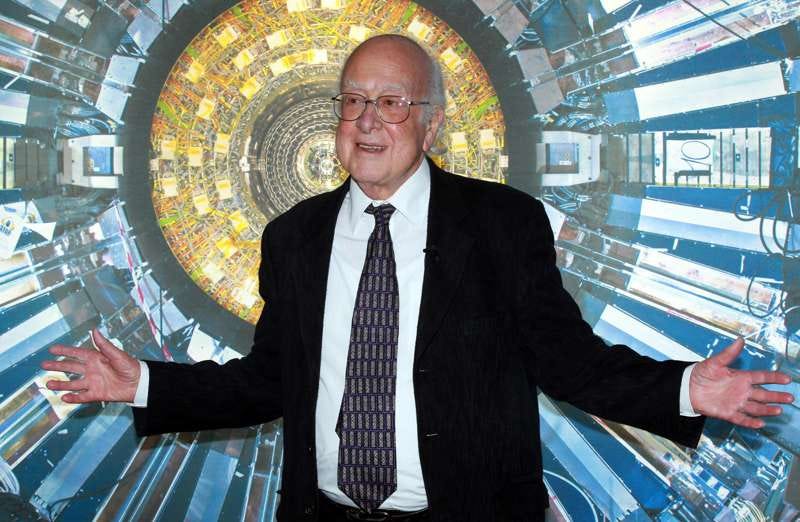

Llevamos un año de despedidas que estremecen. Hace unos días nos despedimos de Frans de Waal, y pocos días después de Peter Kahneman. Hoy quiero hacerme eco del fallecimiento de Peter Higgs, el famoso físico que predijo la existencia del bosón que llevaría su nombre, la partícula subatómica que sería llamada la “partícula más codiciada de la física”. A mediados de 1960, Higgs planteó la ruptura de la simetría en la teoría electrodébil, que explicaba múltiples fenómenos como la masa de las particulares elementales y la existencia de este bosón masivo que fue bautizado con su nombre. Pero a pesar de su precisa apuesta, el bosón de Higgs se resistía empecinadamente a mostrarse. Medio siglo se tardó en comprobar experimentalmente, en el acelerador de partículas del CERN, que la partícula existía. En 2013, un año después del experimento, Higgs recibió el premio Nobel de física, tras cinco décadas. Apenas una más, y no habría podido recibir el galardón, que no se concede póstumamente.

Aunque en cierto modo este ejemplo muestra una vez más cómo la teoría científica se anticipa al desarrollo tecnológico, Higgs no fue reconocido como premio Nobel hasta entonces. Porque la virtud de la ciencia es su imprescindible recurso al contraste con la realidad. No basta la especulación matemática, teórica o incluso metafísica. Y es que, en el fondo, este episodio refrendó una vez una idea más bien opuesta: La del filósofo Ian Hacking que sostiene que todas las revoluciones de la ciencia han sido, esencialmente, revoluciones en las técnicas e instrumentos de observación. Frente a la percepción tradicional que coloca - con razón - a la ciencia como la progenitora y antecesora de la tecnología, Hacking planteaba que la tecnología, especialmente en forma de técnicas e instrumentos de observación, ha sido una fuerza motriz esencial para realimentar y ampliar los horizontes de la ciencia desde sus inicios.

Los instrumentos de observación han catalizado cambios fundamentales en el entendimiento científico pues no se limitan a representar la realidad, sino que también intervienen en ella, creando nuevas formas de entender e interactuar con el mundo. De hecho, no sólo los conceptos están cargados de teoría - como apuntara Hanson -, sino que la propia observación está cargada de práctica competente, es decir, de buen uso en la fabricación y uso de los medios de observación. Conceptualizamos lo que somos capaces de observar. Lo que medimos cobra realidad.

Ni rastro del éter

El telescopio, aunque no fue inventado por Galileo Galilei, fue sustancialmente mejorado por él en el siglo XVII. Inspirado por descripciones vagas de "un dispositivo para ver objetos distantes" patentado en los Países Bajos, y quizá desarrollado en España, Galileo construyó su propio modelo en 1609. Esta mejora no fue un simple incremento en la capacidad de magnificación; fue una transformación que le permitió hacer observaciones astronómicas sin precedentes.

Con su telescopio, Galileo observó montañas y cráteres en la Luna, fases de Venus, y las lunas de Júpiter, proporcionando evidencia sólida contra la ortodoxia geocéntrica y a favor del heliocentrismo de Copérnico. Este cambio de paradigma no solo desafió las concepciones científicas de la época, sino que también reconfiguró la cosmología y la física (filosofía natural, que dirían entonces).

Las primeras interpretaciones de Galileo de sus observaciones fueron radicales: propuso que la Luna era un mundo áspero y variado, no un esfera perfecta hecha de éter tal y como se pensaba anteriormente, y sus descubrimientos de los satélites de Júpiter fueron socavando la noción de que toda orbita celestial debía centrarse en la Tierra. El mundo semejante al terrenal se expandía por la infinidad del Universo. Las inalcanzables esferas divinas se volvían mundos potencialmente accesibles.

Un Nuevo Mundo en una gota de agua

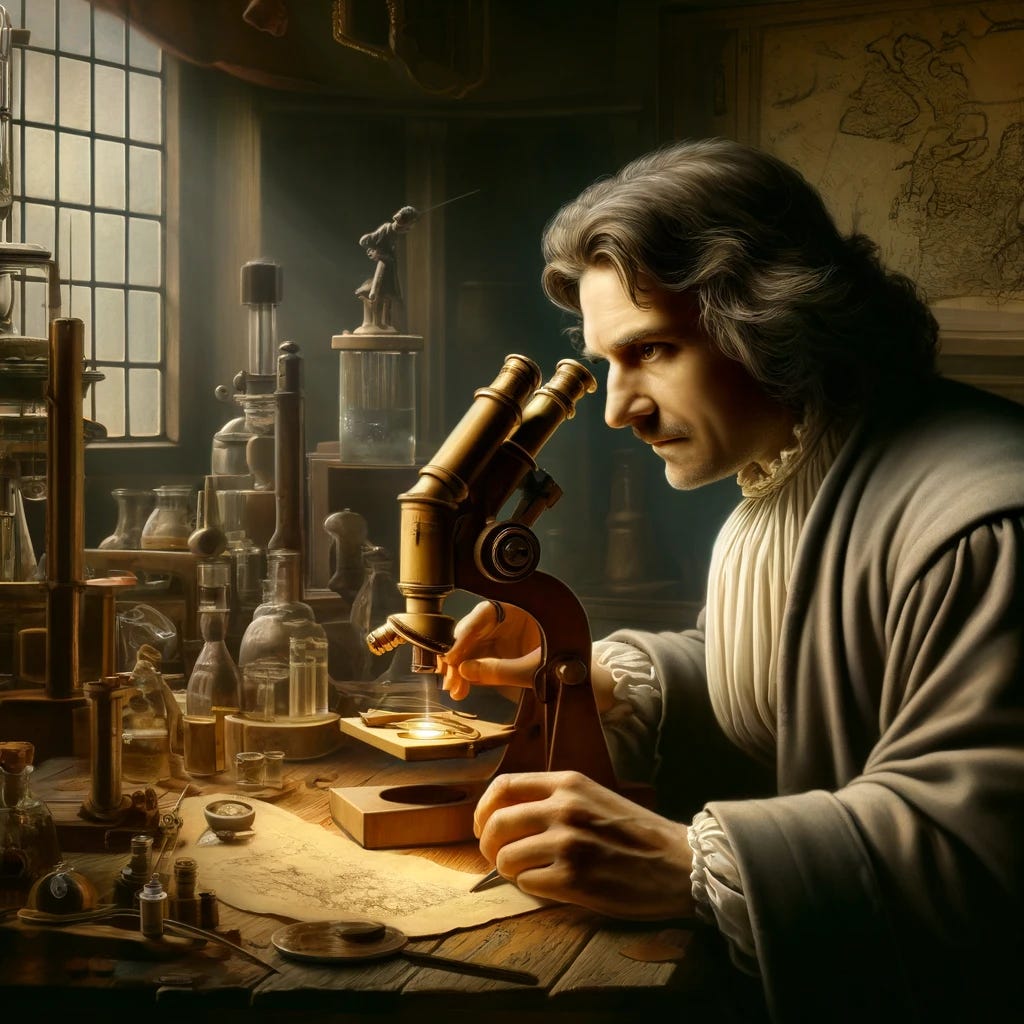

Una aproximación análoga se dio por entonces hacia el mundo de lo diminuto. Antoni van Leeuwenhoek, un comerciante de telas holandés del siglo XVII, comenzó a usar lentes pulidas para examinar la calidad de las telas. Intrigado por lo que podría ver con estas lentes, Leeuwenhoek las perfeccionó hasta crear microscopios con una capacidad de magnificación sin precedentes, alcanzando más de 200 veces el tamaño original. Así logró ser el primero en observar y describir bacterias, protozoos, espermatozoides, y la estructura celular de las plantas y los animales. Estas observaciones abrieron completamente nuevos campos de estudio biológico, como la microbiología y la citología, y cambiaron fundamentalmente la comprensión de los procesos vitales.

Las cartas que Leeuwenhoek enviaba a la Royal Society en Londres, describiendo lo que veía a través de sus microscopios, estaban llenas de asombro y detallaban un universo hasta entonces completamente desconocido. Desde allí criticaban su falta de preparación científica académica, además de su desconocimiento de lenguas extranjeras. Pero la tecnología le había permitido aportar su mirada novedosa, libre de los prejuicios de los anatomistas de la época, y lo catapultó hasta hacerse un hueco entre los grandes, siendo recibido por reyes y altos mandatarios, y convertirse para muchos en el padre de la biología experimental y la microbiología.

Sus descripciones de "animálculos" (microorganismos) desafiaron la entonces predominante teoría de la generación espontánea, sugiriendo que incluso las formas de vida más diminutas tenían reproducción y complejidad. Su descubrimiento de los hasta entonces invisibles espermatozoides llevó a algunos a especular con la idea de que cada uno tenía un diminuto ser humano completamente preformado. En la época en que los navíos de la pequeña y emergente nación neerlandesa se expandían por todo el globo compitiendo contra los titanes europeos, un Nuevo Mundo se abría a su vez en apenas una gota de agua.

Una escala para lo invisible

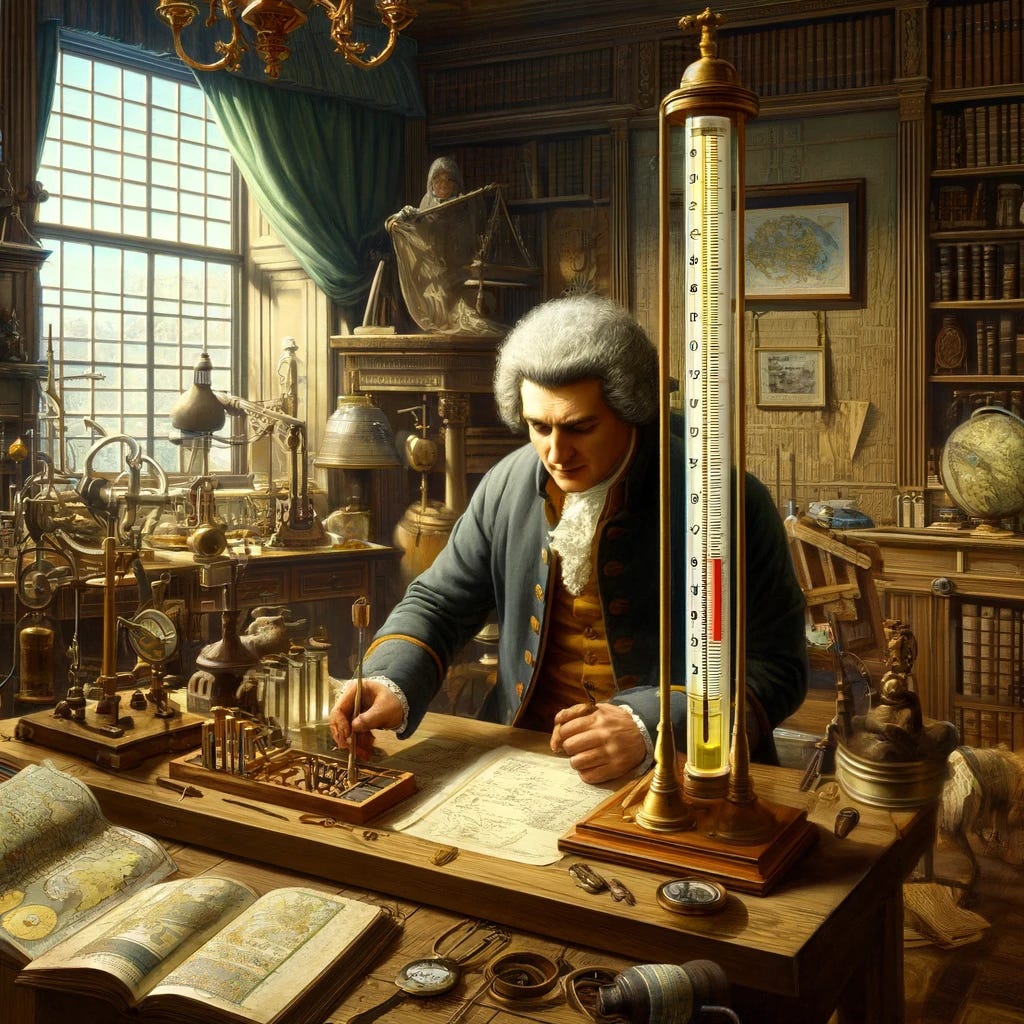

Construir instrumentos para observar mejor lo que vemos resulta intuitivo. Pero si lo que percibimos no es visual, y por tanto resultará siempre invisible, la cosa se complica. Así sucedía con la temperatura, un vago concepto hasta que fue medido. La necesidad de medir con precisión la temperatura fue impulsada inicialmente por la alquimia y la medicina. El genio italiano de Galileo, nuevamente, desarrolló un termoscopio alrededor de 1593, que es considerado uno de los primeros instrumentos de medición, aunque todavía carecía de una escala. Y eso que el de Pisa fue un maestro a la hora de entender que el lenguaje de la naturaleza, como dejó escrito, era matemático.

Aunque hubo antecedentes en ideas de médicos como Galeno o Hasler, parece que fue Daniel Gabriel Fahrenheit quien, en el siglo XVIII, inventó el primer termómetro de mercurio con una escala graduada, estableciendo un estándar para la medición térmica. Esta invención permitió a los científicos llevar a cabo experimentos cuantitativos que eran esenciales para el desarrollo de la termodinámica. También ayudó a establecer los fundamentos de la teoría del calor y facilitó el desarrollo de tecnologías basadas en el control térmico, como la refrigeración y la calefacción.

Las primeras escalas termométricas y los estudios resultantes sobre la expansión y contracción de los gases con el cambio de temperatura llevaron directamente a las leyes de los gases ideales, una pieza fundamental de la física moderna que tiene implicaciones en múltiples ámbitos, desde la meteorología hasta la ingeniería aeroespacial. Hacer visible lo invisible abrió nuevas ventanas.

Una ventana al cuerpo humano

Si existe un objeto de especial predilección en la investigación científica somos nosotros mismos. El estudio anatómico sobre cuerpos, como recuerda el famoso cuadro de Rembrandt, fue durante siglos la única oportunidad para asomarse a este misterio. A finales del XIX, fue un ingeniero, y también físico, el que descubrió la capacidad de algunos elementos de emitir unos rayos decisivos para explorar el cuerpo humano: Wilhelm Conrad Röntgen estrenó el primer premio Nobel de física de la historia por el descubrimiento de los rayos X. Donó el premio a su universidad, y no quiso que los rayos llevaran su nombre, aunque en alemán se siguen conociendo como Röntgenstrahlen (rayos Röntgen).

El mundo que este ingeniero abrió fue decisivo para visualizar el interior del cuerpo humano sin cirugía, transformando el diagnóstico médico sobre fracturas óseas, tumores y anomalías internas. Pero también abrió enormes campos para que prosperara la química y la física permitiendo el análisis de la estructura atómica de los cristales, e incluso a descifrar la estructura de materiales complejos, incluyendo biomoléculas como el ADN.

Los principios de la física nuclear y el magnetismo permitieron extender esta penetración hasta la imagen por resonancia magnética (MRI) que, en los años 1970, Raymond Damadian y otros investigadores emplearon para visualizar el interior del cuerpo humano, aprovechando la distribución de átomos de hidrógeno en el cuerpo y proporcionando imágenes detalladas de los tejidos blandos. La resonancia magnética revolucionó la medicina mejorando drásticamente la capacidad de diagnóstico en enfermedades del cerebro, la columna vertebral, las articulaciones y los tejidos blandos, y resultando fundamental para el desarrollo de la neurociencia.

Además de su impacto en la medicina, la MRI ha cambiado nuestra comprensión de la biología humana y la salud. Ha proporcionado nuevos métodos para el estudio de enfermedades psiquiátricas y degenerativas, ha abierto el camino para terapias dirigidas más precisas, y ha desafiado nuestras concepciones previas sobre la recuperación de lesiones cerebrales y otras condiciones, lo que ha llevado a enfoques completamente nuevos en la medicina y la rehabilitación.

La partícula de Dios

En el siglo XIX los tubos de rayos catódicos fueron utilizados por científicos como J. J. Thomson para descubrir el electrón. Inspirados en ellos y con una poderosa inversión en la era de la Big Science, surgieron los aceleradores de partículas. En la primera mitad del siglo XX, la tecnología avanzó hacia la construcción de ciclotrones y sincrotrones, permitiendo a los físicos acelerar partículas a velocidades extremadamente altas y estudiar las propiedades fundamentales de la materia a niveles nunca vistos antes.

Los aceleradores de partículas han sido esenciales para la física moderna, permitiendo a los científicos explorar la estructura fundamental de la materia. Gracias a estas máquinas, se ha podido validar el Modelo Estándar de la física de partículas hasta la fecha. La capacidad de observar partículas subatómicas y sus interacciones ha cambiado no solo nuestra comprensión del universo a una escala microscópica, sino también cómo conceptualizamos la masa, la energía y las leyes fundamentales del cosmos. Experimentos en aceleradores como el Gran Colisionador de Hadrones han cuestionado y extendido teorías físicas, proporcionando una base para posibles nuevas teorías que abarquen aún más fenómenos, incluida la materia oscura y la energía oscura.

De hecho, el acelerador permitió el descubrimiento de conocidas partículas como el quark y, desde luego, el famoso bosón de nuestro querido Higgs. Aunque evidentemente los científicos implicados fueron muchos, parece que Higgs acabó ganando notoriedad para acabar dando nombre a la partícula porque fue el que más clara y explícitamente se atrevió a predecir y a calcular formalmente algunas de sus propiedades desde la teoría. Quizá arriesgó más que otros autores, que fueron más difusos en sus teorizaciones, y ofreció un objetivo concreto crucial para probar la teoría, que quedó a la espera del desarrollo tecnológico que hiciese posible su comprobación empírica. Miles de millones de euros y medio siglo después, Higgs alcanzó el máximo reconocimiento del Nobel por el aval experimental que permitió la tecnología. Algunos, no sin polémica, acabaron nombrándola la partícula de Dios, en cierta forma buscando cierta provocación sobre esta nueva frontera pendiente de una próxima superación que resuelva inconsistencias y misterios remanentes.

El infinito en la palma de la mano

Escribía el poeta y pintor William Blake: “Para ver un mundo en un grano de arena y el cielo en una flor salvaje, abarca el infinito en la palma de tu mano y la eternidad en una hora.” Sin duda no habría habido tecnología sin ciencia. La ciencia requiere y estimula la reflexión del artesano y la meditación del técnico hasta convertirlos en ingenieros. Pero estos ejemplos históricos aquí reunidos y otros tantos más refuerzan la, en ocasiones, olvidada idea de Hacking y demuestran que los instrumentos de observación son mucho más que meras herramientas pasivas; son agentes de cambio en la ciencia. La ciencia prospera porque es acumulativa, porque, como decía Bernardo de Chartres y Newton popularizó, permite ver más lejos aupados sobre los hombros de gigantes. Pero estos hombros no son sólo conceptuales o empíricos, sino también tecnológicos, hechos de hierro y vidrio. La ampliación de nuestro perímetro de observación no solo ha extendido nuestro conocimiento, sino que ha revolucionado nuestras teorías científicas y la manera en que comprendemos el mundo. Los instrumentos no solo capturan la realidad, sino que también la moldean, interviniendo activamente en los fenómenos que estudiamos.

Y sin embargo, precisamente por esta interdependencia, surgen cuestiones inevitables… ¿podemos estar asistiendo a una ralentización en este desarrollo tecno-científico? ¿puede estar tocando techo nuestra capacidad para desarrollar la ciencia más fundamental, como la física? Alejada ya de nuestro mesocosmos, y enfrentada a la frontera más extrema del macro y del microcosmos, ¿es posible que la física teórica se haya desconectado de la experimental? ¿no está sucediendo ya que la física teórica sigue especulando con sus matemáticas sobre el papel, desarrollando teorías cada vez más incomprobables (como la teoría de cuerdas) y la física experimental a duras penas le siga a la zaga con experimentos cada vez más costosos y de dudoso retorno?

Desde que lo nombrara por primera vez, Thompson tardó 7 años en poder probar experimentalmente la existencia del electrón. La teoría de la relatividad de Einstein, desde la primera vez que la expuso, tardó el doble en ser verificada. Cinco décadas de necesario desarrollo tecnológico estuvieron a punto de privar a Higgs del Nobel. ¿Las manzanas del árbol de la ciencia se encuentran cada vez más altas y comienzan a resultarnos prohibitivas? Aunque todavía nos quede mucho por progresar en ámbitos estremecedoramente interesantes como el de la biología molecular y la genética, ¿nos acercamos social o psicológicamente a algún límite en nuestra capacidad científica para la comprensión del cosmos? ¿Y si no somos nosotros la especie elegida para desarrollar la llamada teoría del todo? ¿Y si la tecnología precisa de una nueva revolución - ¿como la de la IA? - para seguir haciendo crecer el infinito en la palma de nuestra mano? En esta trastienda tecnológica de la ciencia aún hay muchísima tela que cortar.