Protágoras y el Metaverso

El cuello de botella de la usabilidad antropomorfa

Nuestra especie se fraguó a través de la tecnología. Sin ella no sería comprensible su emergencia. Golpeando piedras y dominando el fuego alteramos nuestra dieta, nuestra fisiología, nuestro cerebro, nuestro hábitat y nuestra forma de estar en el mundo, hasta forjarnos a nosotros mismos. Sin embargo, el objeto tecnológico es siempre un artefacto ajeno para el hombre. Lo crea como prolongación de su naturaleza, y al mismo tiempo lo extraña. La tecnología ciertamente no sería comprensible sin el ser humano, pero no deja de resultar algo distinto de él, un producto de su mano al que debe adaptarse.

Porque ciertamente nuestro cerebro trata de proyectar la información de su imaginación en la realidad material, pero la realidad material siempre contrasta con la idea preconcebida. Su uso real siempre requiere de aprendizaje. Desde el proceso de creación se constata la brecha que, a continuación, habremos de intentar salvar. Para aprovechar el beneficio de la tecnología y extraer de ella una nueva forma de facilitarnos o disfrutar de la vida siempre hemos tenido que lidiar con esta brecha. Y en el camino de ese aprendizaje, sin duda, hemos ideado muchas nuevas formas de hacer mejor tecnología.

Milenios después, nuestro proceso de innovación tecnológica ha evolucionado y ha comprendido que para tener éxito y expandirse masivamente debe desarrollar mecanismos que traten de salvar esta brecha, mejorando su diseño para que sea la tecnología la que se aproxime lo más posible al usuario final, maximice su usabilidad, se adapte a su forma natural. En definitiva, converja antropomórficamente.

Por eso podríamos tomar prestada aquella frase de Protágoras, que decía que “el hombre es la medida de todas las cosas”. Si bien el filósofo la utilizaba para otro propósito1, concedámonos la licencia de usarla para ilustrar que no hay tecnología que triunfe que no haya entendido que la experiencia del usuario determina su éxito. Que la verdadera tecnología no lo es si no se hace auténticamente a la medida del hombre.

La convergencia antropomorfa de las TIC

La naturaleza humana ha inspirado el desarrollo tecnológico y ha sido a la vez su principal objetivo. Los ejemplos podrían alargar una lista interminable. Pero por lo general se ha asumido que el hombre tiene siempre que salvar la brecha aprendiendo a usar la tecnología: es preciso practicar el equilibrio sobre la bicicleta, el manejo de un embrague, adiestrarse con la cortadora de césped o incluso adecuar la postura a unas tijeras.

Sin embargo, el éxito de la revolución de las TIC ha descansado en buena medida en su decidida apuesta por la convergencia antropomorfa. Porque si el ser humano destaca como especie es por su singular capacidad para percibir, procesar e intercambiar información. Y por ello, aquellas tecnologías dedicadas a la información han entendido como esencial que su éxito depende de su capacidad para aprender de los mecanismos humanos que la manejan y adaptarse a ellos lo más posible. Pues uno no tiene que aprender a ver, ni a tocar, ni a oler, ni a sentir, ni a gustar. O al menos lo hace de una forma tan natural y temprana que las TIC han cifrado en gran medida su éxito en aproximarse al máximo posible a estas cinco interfaces humanas.

En ese sentido, las TIC llevan más de medio siglo imitando y aproximándose a la figura humana, convergiendo en ella. Por ejemplo:

La fabricación de transductores para la instrumentación electrónica ha tratado de emular nuestros órganos sensoriales, como en el altavoz o los micrófonos del teléfono.

Las técnicas de predicción, compresión y codificación de datos se han desarrollado según los perfiles y el conformado del tráfico que generan los seres humanos, por ejemplo en los del tracto vocal humano para los codecs de las primeras redes móviles GSM.

Los métodos de redundancia en el intercambio de información emulan los de la comunicación natural humana, como la expresividad oral, e implementan sistemas de asentimientos cruzados como los ACKs del protocolo TCP de Internet.

Emulando a las conversaciones humanas, se han desarrollado mecanismos para resolver problemas de simultaneidad en el intento de transmitir en medios compartidos, como en el protocolo de CSMA/CA, o la multiplexación por código, como en el protocolo CDMA, al estilo de las conversaciones simultáneas entre dos hablantes y dos sordomudos, o entre hablantes de distintos idiomas.

La programación orientada a objetos o las últimas tendencias en no code o low code tratan de simplificar y hacer intuitivo el desempeño natural humano en medio de los objetos y el lenguaje natural, para hacer familiar el diseño y uso de aplicaciones.

La explosión de la IA generativa, con el desarrollo de los LLMs, descansa en su capacidad para haber mejorado enormemente la interacción humano-máquina, enfocándose obsesivamente en maximizar la función que hace verosímil su producción y procesamiento de lenguaje natural humano.

…

Las compañías que han sabido parecerse y facilitar la vida al usuario, mejorando su experiencia, han logrado triunfar. Las pantallas táctiles, por ejemplo, mucho más dóciles que el intrincado uso de un teclado o un ratón, han disparado la usabilidad de los dispositivos, expandiéndose entre niños y mayores. Los algoritmos que rastrean el uso real de aplicaciones y realimentan su diseño han permitido que distintas plataformas de contenido de vídeo o música hayan triunfado haciendo que los usuarios fluyan y se mantenga fieles, hasta niveles en ocasiones adictivos. De hecho, parece que las empresas utilizarán el neurofeedback para personalizar productos y experiencias. Además, hemos conocido recientemente cómo Elon Musk y su tropa han implantado ya un chip de Neuralink en el cerebro de una persona, como analiza magníficamente Sergio Parra . La brecha se va estrechando.

No obstante, cabe recordar que, aunque aún manido, el mito de los nativos digitales supuestamente capaces de fluir naturalmente con la tecnología está más que desacreditado: la familiaridad desde la infancia con ella no garantiza automáticamente un entendimiento profundo de cómo funciona realmente o cómo usarla de manera efectiva y creativa. Las habilidades digitales requieren de aprendizaje y no son una cuestión generacional. La brecha sigue siendo un reto que se reabre, especialmente con cada innovación.

Por eso, cualquier desarrollo de la tecnología que facilite salvarla siempre debe poner en el centro esta versión adaptada de la máxima de Protágoras. La ingeniería del software y la del hardware, de hecho, llevan décadas entendiendo que la incorporación de psicólogos, antropólogos o sociólogos es esencial para evitar el rechazo tecnófobo o simplemente neófobo a los nuevos terminales y aplicaciones. Con ello, el éxito de esta convergencia antropomorfa de las TIC es razonablemente indiscutible: para la mayoría se aprende mucho antes a hablar por teléfono, ver la tele, navegar por Internet, o enviar un email que a conducir, a cocinar o a hacerse un nudo de corbata.

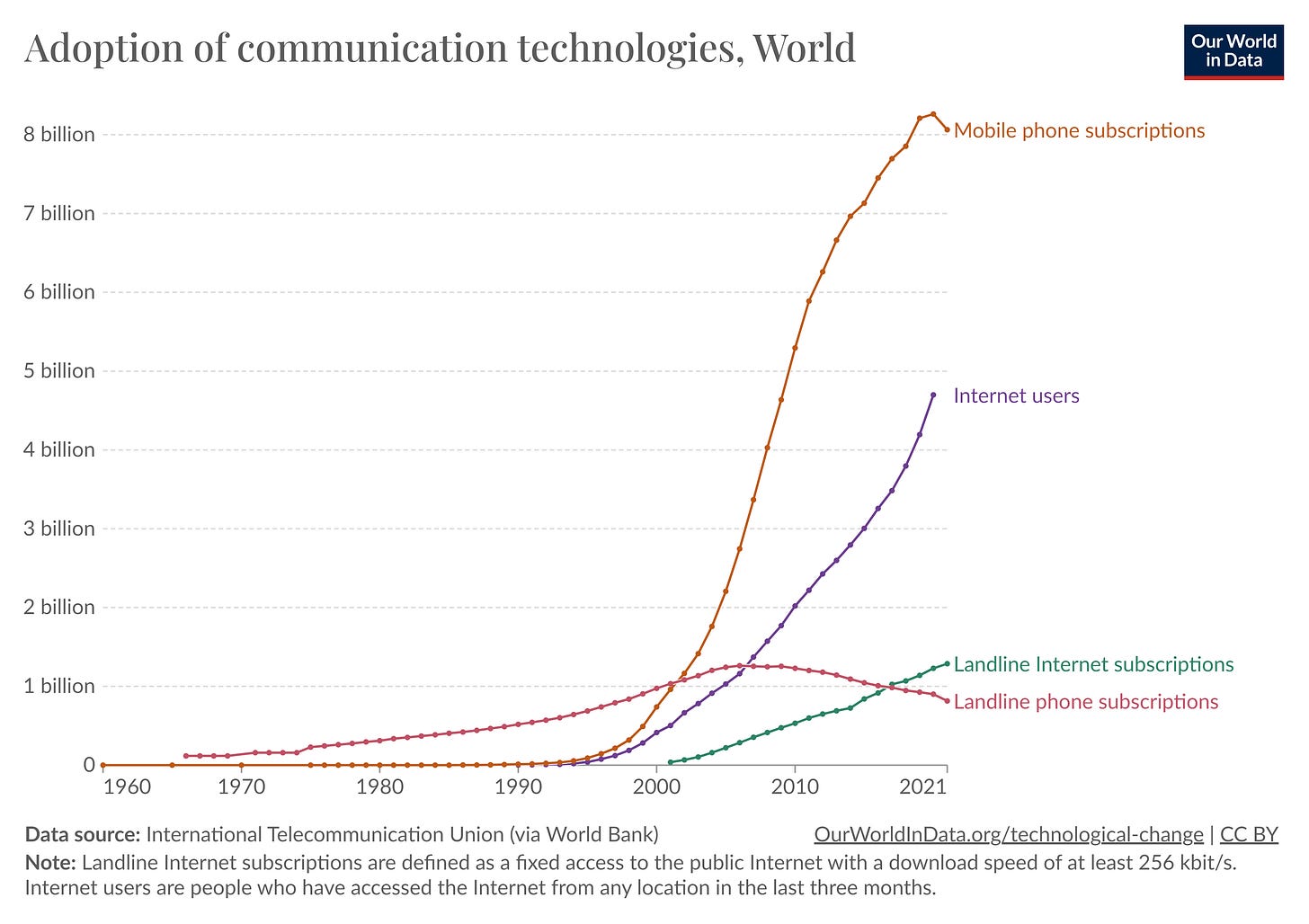

El boom antropomorfo de Internet

Internet era una buena idea de finales de los años sesenta del siglo pasado. Iba a permitir conectar ordenadores a través de una red en la que podrían intercambiar información de forma distribuida y resiliente, creando valor aprovechando el sorprendente efecto red. Además, la ley de Moore prometía proporcionarnos ordenadores potentes y baratos en cuestión de tiempo. Así, la emergencia a principios de los noventa de los protocolos HTTP dio un impulso muy relevante. Pero hasta que la telefonía móvil con acceso a Internet, y en particular los smartphones, no irrumpieron hasta mediados de la primera década del siglo XXI2, el número de usuarios de Internet no explotó mundialmente. Y en ello tuvo un papel central la aproximación antropomorfa, en varios aspectos. Baste mencionar dos de ellos que resultaron claves:

Adaptarse a la realidad inalámbrica humana fue determinante. No hay que perder de vista que el único enchufe físico del ser humano acaba cuando se corta su cordón umbilical. La movilidad hizo a Internet ubicua. Anytime, anywhere.

A pesar de las inmensas transformaciones socioculturales, seguimos contando con el mismo par de bolsillos que hace siglos. Esta obviedad tan simple chocaba con las innovaciones TIC. Era inhumano hacernos cargar con la multitud de dispositivos que nos ofrecía la nueva era digital. Eso forzó su convergencia hasta hacer del smartphone el dispositivo que reunía lo que antes estaba distribuido en varios (cámaras digitales, reproductores de música, teléfonos, agendas electrónicas, geolocalizadores, tarjetas bancarias, tarjetas de identidad,…).

Un nuevo cuello de botella para el Metaverso

El desarrollo del Metaverso ha captado la atención y la imaginación de millones de personas en los últimos años, solo eclipsadas por el auge más reciente de la IA. La posibilidad de experimentar mundos virtuales inmersivos que van más allá de lo que es posible en el mundo físico ha abierto el apetito de muchos. En seguida han surgido ideas para aumentar y mejorar la interacción social, la creatividad y la colaboración en un entorno digital, capaz de ofrecer nuevas formas de entretenimiento, trabajo, educación y comercio. Otro día volveremos sobre el motor profundo, más allá del económico, que puede hacer atractivo este nuevo espacio.

Pero para una adopción masiva, la interfaz de usuario y su experiencia en el metaverso son aspectos críticos. Los dispositivos deben ofrecer interfaces intuitivas y experiencias de usuario fluidas para garantizar una navegación cómoda y atractiva. Y que además puedan proyectar precios asequibles por economía de escala para evitar nuevas brechas digitales y así facilitar un acceso casi universal. Es necesario que surja un nuevo smartphone que permita la irrupción del metaverso como en su día sucedió con Internet.

Los movimientos de los últimos años han disparado las expectativas al respecto. Facebook se renombró como Meta, invirtiendo cantidades ingentes de dinero. Google, Microsoft y por supuesto Apple han hecho importantes apuestas por su desarrollo. Acabamos de saber que Disney, después de acaparar buena parte de los contenidos de vídeo, se ha lanzado ahora a por los de los videojuegos, con una masiva inversión en Epic games, el promotor del famoso juego Fortnite, el cual podría estar materializando del Metaverso lo que Meta no ha logrado hasta ahora.

Pero la brecha en esta convergencia antropomorfa sigue ahí. Las flamantes Vision pro de Apple, así como sus primas hermanas, han acelerado estas expectativas, pero aún tienen un proceso de adaptación y adopción por delante. De hecho, algunos fans han comenzado a devolver las costosas gafas por distintos problemas de usabilidad.

Sin duda, es prematuro condenar a este tipo de dispositivos, pues como nos cuenta Alex Rayón Jerez, basta un poco de memoria para recordar cómo se despreciaba al portátil porque nunca sería mejor que llevar un disquete en el bolsillo, o al iPhone como un mero Ipod con capacidades para llamar.

Hay quienes han querido ver una mano negra en este posible fiasco ergonómico, porque la fabricación y prototipado de Apple se desarrolla en China, donde intereses geopolíticos podrían haber interferido. Empresas del gigante asiático como Huawei o Xiaomi prometen sacar en breve dispositivos más ligeros y baratos.

Sea de una forma u otra la convergencia antropomorfa de las TIC seguirá confirmando que, en varios sentidos, el hombre sigue siendo la medida de todas las cosas, como quisiera el viejo Protágoras.

Se atribuye a Protágoras (s. V a.C.) esta frase que pretende sintetizar la idea relativista de que la realidad es percibida y evaluada por los seres humanos desde su propio punto de vista individual, y que no hay una verdad objetiva universal que exista independientemente de la experiencia humana. El hombre juzga lo que es verdadero en función de lo que a él se lo parece.

Como referencia, el Iphone salió en 2007, Android en 2008.

Cuando leí sobre el mareo y las gafas immersivas me explotó la cabeza. ¿Cómo algo así no ha sido más testeado antes de venderse? He leído que algo tiene que ver el reparto de masas de las gafas, pero no soy un experto. Desde luego, si es así y es imposible evitar el mareo, estos horizontes y nuevas tecnologías tendrán un buen problema.

Como decía Edward. O. Wilson: "Tenemos emociones paleolíticas, instituciones medievales y tecnología casi divina"